问题定义

实验内容

使用 Spark 对数据进行处理,并分析双十一的用户交易等信息,用 Scala 语言进行程序编写,最后将处理的数据结果使用 Echarts 进行可视化。

实验环境以及使用的相关应用:

- Spark 2.4.3

- Scala 2.12

- Tomcat 9.0.20

- 可视化工具:ECharts

- Java 包:fastjson

- 系统环境:macOS Mojave 10.14.5

使用 Spark 对数据进行处理,并分析双十一的用户交易等信息,用 Scala 语言进行程序编写,最后将处理的数据结果使用 Echarts 进行可视化。

实验环境以及使用的相关应用:

弹性分布式数据集 (Resilient Distributed Datasets, RDD)

RDD,全称 Resilient Distributed Datasets(弹性分布式数据集),是 Spark 最为核心的概念,是 Spark 对数据的抽象。

RDD 是分布式的元素集合,每个 RDD 只支持读操作,且每个 RDD 都被分为多个分区存储到集群的不同节点上。除此之外,RDD 还允许用户显示的指定数据存储到内存和磁盘中。

对 RDD 的操作,从类型上也比较简单,包括:创建 RDD、转化已有的 RDD 以及在已有 RDD 的基础上进行求值。

HDFS 和 MapReduce 是 Hadoop 的两个重要核心,其中 MapReduce 是 Hadoop 的分布式计算模型。MapReduce 主要分为两步 Map 步和 Reduce 步,引用网上流传很广的一个故事来解释,现在你要统计一个图书馆里面有多少本书,为了完成这个任务,你可以指派小明去统计书架 1,指派小红去统计书架 2,这个指派的过程就是 Map 步,最后,每个人统计完属于自己负责的书架后,再对每个人的结果进行累加统计,这个过程就是 Reduce 步。

本代码运行环境为 ubuntu 18.04,使用 Hadoop 2.9.2 版本

首先按照之前的方法(在 CentOS 7 中安装 Hadoop 与 HBase)搭建并启动 Hadoop

Hadoop HDFS 实践(2)—— 使用 Java 编程操作 HDFS 文件

接着上一篇:Hadoop HDFS 实践(1)—— 安装 IDEA 并创建项目

本笔记主要内容如下:

Hadoop HDFS 实践(1)—— 安装 IDEA 并创建项目

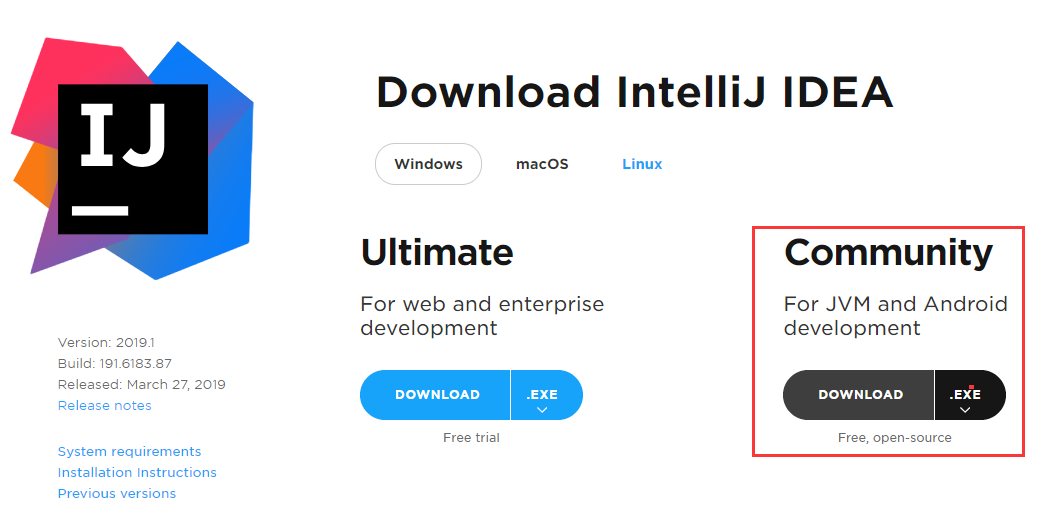

本实验使用 IntelliJ IDEA 2019.1 创建项目,使用 maven 管理依赖。

进入官网,下载 Windows 版本的 IDEA(直达链接:https://www.jetbrains.com/idea/download/#section=Windows),这里选择 Community 版本。

本实验在 VMware 虚拟机中安装 CentOS 系统,搭建 Hadoop 伪分布式模式环境,安装 HBase。实验必要的环境,包括:VMware Workstation Pro 15, CentOS 7.6.1810, Java SE Development Kit 8u201, Hadoop 2.9.2, HBase 1.4.9。

下载地址:

本报告一共分为四个部分